Ingenieros

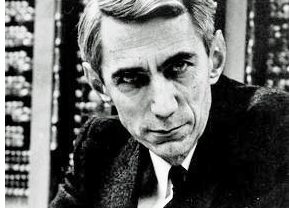

Claude Shannon

Biografía de Claude Shannon

Claude Shannon (30 de abril de 1916 – 24 de febrero de 2001) ingeniero y padre moderno de la teoría de la información. Nació en Petoskey, Michigan, Estados Unidos. Es conocido por haber analizado las unidades de información (bits) y su pérdida en los procesos de transmisión. Terminó la secundaria en 1932. En la escuela, Shannon desarrolló un gusto por los temas relacionados a la mecánica. Se destacó en las áreas relacionadas con las ciencias. Leyó mucho sobre Thomas Alva Edison y lo tomó como referencia.

En el año de 1936 obtuvo los títulos de ingeniero electricista y matemático en la Universidad de Míchigan. Al poco tiempo, se le ofreció un puesto como asistente de investigación en el departamento de ingeniería eléctrica en el Instituto Tecnológico de Massachusetts (MIT). Durante este tiempo adelantó varias investigaciones mientras trabajaba por horas para el departamento. Su principal trabajo se centró en el analizador diferencial de Vannevar Bush, básicamente era una calculadora analógica.

Luego, se acercó al problema de la eficacia de los diferentes métodos existentes de transmisión de la información, mediante el flujo de hilos o cables como el aéreo, se valió de corrientes eléctricas fluctuantes o moduladas por la radiación electromagnética. El ingeniero estadounidense orientó sus esfuerzos a este tema y en 1948 desarrolló un método que lograba expresar la información de forma cuantitativa.

En 1949 creó el bit: una unidad para medir información. Este concepto ya había sido acuñado por John W. Tukey, solo que Shannon lo complementó. La creación de esto fue:

un puente que llevaba de las matemáticas a la ingeniería eléctrica, y de allí, a la Informática.

– James Gleick.

Realizó varias publicaciones en la década de los cincuenta que demostraban la manera de analizar la magnitud de un BIT, esto lo hizo mediante métodos matemáticos. Así, midió la probabilidad de la información mutilada por pérdidas de bits, la distorsión, adición de elementos extraños, etc. Shannon fue el creador de la nueva vertiente matemática: teoría de la información realmente aportó al diseño de circuitos de computadoras y la tecnología de comunicaciones, también ha sido utilizado en campos como la biología, la psicología, la fonética e incluso la literatura.

Fue el responsable de postular el teorema del muestreo, esta indica que una señal debe ser muestreada al doble de su frecuencia natural (o, en otro caso, al doble de la mayor de las frecuencias de dicha señal), para que no se produzca el fenómeno de aliasing (aparición de componentes frecuenciales no deseadas). En 1956 ingresó como profesor en el Massachusetts Institute of Technology.

Su aporte impactó la manera cómo se ordenaban los libros en las bibliotecas, de ese modo fue más sencillo realizar búsquedas en catálogos de bibliotecas o en bases de datos de centros de documentación. En definitiva, aportó a la biblioteconomía y la documentación. Gracias a su labor recibió múltiples condecoraciones y reconocimientos de universidades e instituciones de diferentes partes del mundo. Fue miembro de varias instituciones de renombre: Real Academia de Artes y Ciencias de los Países Bajos, Academia Nacional de Ciencias (1956), Academia Estadounidense de las Artes y las Ciencias (1957), Academia Alemana de las Ciencias Naturales Leopoldina (1970), y la Sociedad Filosófica Estadounidense (1983). Con el paso del tiempo su enfermedad de Alzhéimer se fue agravando hasta llegar a su descenso en 24 de febrero de 2001.